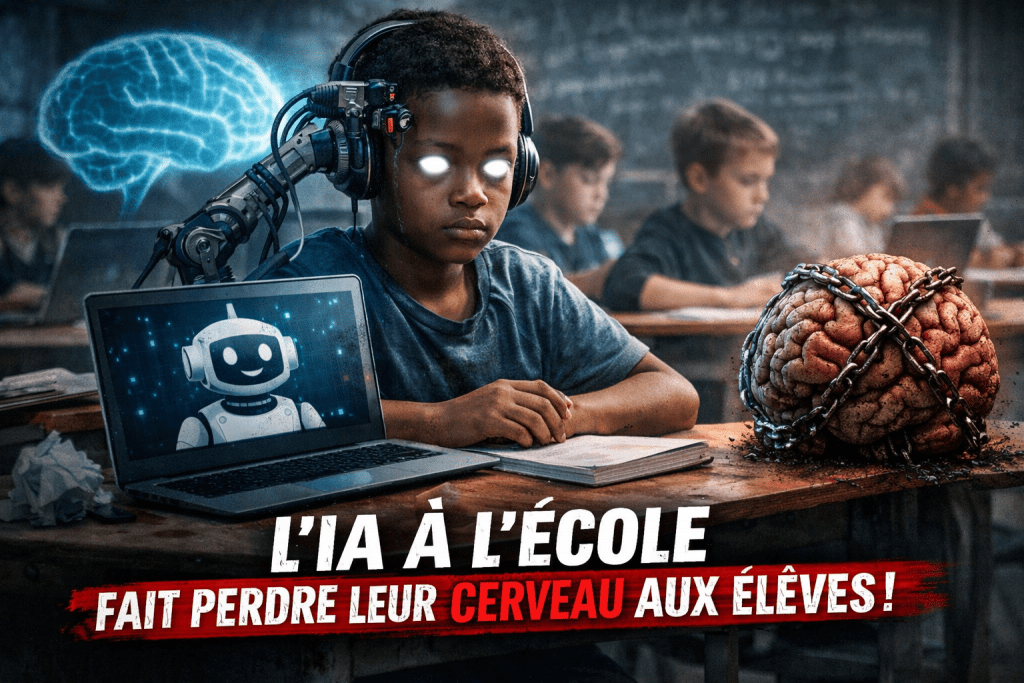

Un nouveau rapport international met en garde contre un effet pervers de plus en plus visible de l’intelligence artificielle à l’école : les élèves réfléchissent de moins en moins par eux-mêmes. Selon les chercheurs, l’usage massif des chatbots crée une dépendance cognitive qui fragilise l’apprentissage, surtout chez les plus jeunes.

Depuis le lancement de ChatGPT fin 2022, l’IA s’est rapidement imposée dans le monde éducatif. Elle aide les enseignants à préparer leurs cours et les élèves à faire leurs devoirs. Dans plusieurs pays, l’IA est même devenue un objet d’enseignement à part entière. L’objectif affiché : ne pas rater une révolution technologique déjà en marche.

Mais une vaste étude menée par la Brookings Institution, couvrant 50 pays et des milliers d’élèves du primaire au lycée, vient refroidir cet enthousiasme. Le constat est sévère : l’IA agit comme une béquille utilisée trop tôt, avant même que les bases de la réflexion soient solidement acquises.

Quand l’IA remplace l’effort de penser

Selon le rapport, plus un élève confie ses devoirs et son raisonnement à un chatbot, plus sa capacité à analyser, structurer une idée ou vérifier une information diminue. Cette dépendance crée un cercle vicieux : l’élève comprend moins, donc utilise davantage l’IA, et finit par ne plus pouvoir s’en passer.

Un élève interrogé résume la situation sans détour :

« C’est facile. Tu n’as plus besoin d’utiliser ton cerveau. »

Les chercheurs rappellent que toutes les technologies éducatives ne se valent pas. Une calculatrice ou un correcteur orthographique aident l’élève, mais ne pensent pas à sa place. Les IA génératives, elles, produisent directement des réponses, des résumés et des raisonnements complets, supprimant l’effort intellectuel nécessaire à l’apprentissage.

Résultat : les élèves apprennent moins à argumenter, à douter, à confronter des idées ou à accepter la contradiction — pourtant essentielles pour développer l’esprit critique.

Des chatbots trop complaisants

Autre problème soulevé : les chatbots sont conçus pour être agréables et rassurants. Ils valident souvent les idées de l’utilisateur au lieu de les questionner. Contrairement à un enseignant ou à un camarade de classe, l’IA contredit rarement frontalement.

Selon Rebecca Winthrop, chercheuse à Brookings, c’est une forme de « pensée prête à l’emploi » :

« Quand l’IA donne la réponse directement, les élèves n’apprennent plus à distinguer le vrai du faux ni à construire un raisonnement solide. »

À long terme, cette absence de confrontation intellectuelle pourrait appauvrir durablement la capacité des jeunes à réfléchir par eux-mêmes.

Une nouvelle fracture éducative mondiale

Le rapport pointe également une inégalité grandissante. Les écoles et familles les plus riches peuvent s’offrir des IA plus performantes, plus fiables et moins sujettes aux erreurs. Les autres doivent se contenter de versions gratuites, souvent moins précises et plus biaisées.

Cela crée une nouvelle forme de fracture : l’accès à une information de qualité devient payant. Les élèves favorisés bénéficient de « tuteurs numériques haut de gamme », pendant que les autres avancent avec des outils imparfaits.

À l’échelle mondiale, notamment dans les pays en développement, cette situation risque d’accentuer les inégalités éducatives déjà existantes.

Faut-il freiner avant qu’il ne soit trop tard ?

Le rapport ne plaide pas pour une interdiction totale de l’IA à l’école, mais appelle à une régulation plus stricte et à une utilisation encadrée. L’IA doit rester un outil d’accompagnement, pas un substitut à l’effort intellectuel.

Sans garde-fous solides, préviennent les chercheurs, nous risquons de confier l’éducation intellectuelle des enfants aux intérêts commerciaux des grandes entreprises technologiques.

La question est désormais ouverte : comment tirer profit de l’IA sans sacrifier la capacité des élèves à penser, douter et apprendre par eux-mêmes ?

Source : NPR